OpenAI setzt bei neuem KI-Code-Modell erstmals auf Cerebras-Chips

14.02.2026 - 13:01:12OpenAI bricht mit seiner Nvidia-Abhängigkeit und startet ein Echtzeit-Coding-Modell auf alternativer Hardware – ein strategischer Schachzug, der die KI-Landschaft verändern könnte.

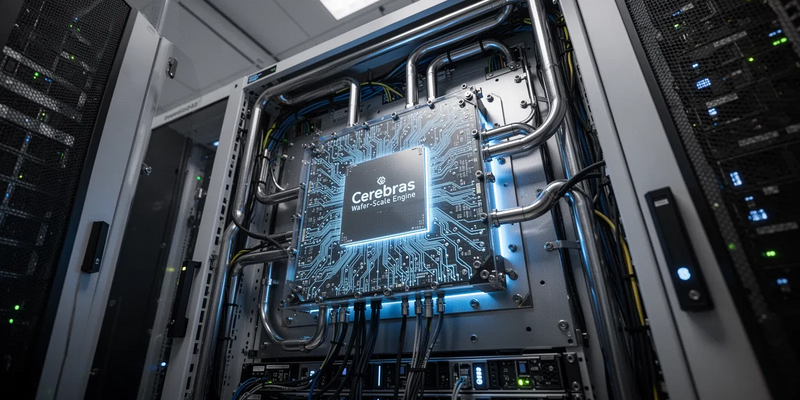

Mit GPT-5.3-Codex-Spark hat OpenAI am Mittwoch eine spezialisierte KI für Software-Entwickler veröffentlicht. Das Besondere: Das Modell läuft erstmals nicht auf Nvidia-GPUs, sondern ausschließlich auf Cerebras Wafer-Scale Engine 3-Chips. Dieser Wechsel der Hardware-Architektur markiert eine Zeitenwende für den KI-Marktführer und könnte die Abhängigkeit von einem einzigen Chip-Hersteller langfristig aufbrechen.

Echtzeit-Coding als neuer Benchmark

Das neue Modell soll Entwicklern als sofortiger „Spark“ (Funke) im Arbeitsfluss dienen. Es generiert, debuggt und verbessert Code in Echtzeit – und ist laut OpenAI etwa 15-mal schneller als Vorgängermodelle. Ein Kontextfenster von 128.000 Tokens erlaubt es, große Code-Basen zu verarbeiten, während es gleichzeitig für Autovervollständigung und Inline-Bearbeitung agil genug bleibt.

Seit dem 12. Februar ist die KI in einer Forschungsvorschau für ChatGPT Pro-Nutzer verfügbar. Sie ergänzt das Basismodell GPT-5.3-Codex, das seit dem 5. Februar komplexe, langfristige Technikprobleme löst. Diese Aufteilung in „Denk“- und „Handlungs“-Modelle setzt eine Strategie fort, die OpenAI bereits mit seiner „o-series“ für logisches Schlussfolgern eingeführt hat.

Cerebras-Chips ersetzen Nvidia-GPUs

Die größte Überraschung der Ankündigung steckt in der Technik unter der Haube. Branchenberichte bestätigen: GPT-5.3-Codex-Spark ist das erste OpenAI-Modell, das vollständig auf der Wafer-Scale-Engine-3-Architektur von Cerebras läuft.

Das ist ein strategischer Paukenschlag. Bisher dominierte Nvidia-Hardware die Recheninfrastruktur des KI-Pioniers. Die Cerebras-Chips sind jedoch speziell für große Sprachmodelle designed. Ihre enorme Chip-Größe und integrierte Hochgeschwindigkeits-Speicher sollen die typischen Engpässe bei Verknüpfungen und „Sparsity“ effizienter lösen als klassische GPU-Cluster.

Was treibt den Wechsel an? Analysten sehen zwei Hauptgründe: die Senkung der Inferenz-Kosten bei hochfrequenten Tasks wie Coding – und die Reduzierung von Lieferkettenrisiken angesichts des globalen Nvidia-Engpasses. Zeigt sich die Cerebras-Hardware in der Produktion als stabil, könnte das die Machtverhältnisse auf dem KI-Hardware-Markt nachhaltig verschieben.

Deep Research Tool wird professioneller

Parallel zum Modell-Release hat OpenAI sein Deep Research-Tool deutlich aufgewertet. Die Agenten-KI für komplexe, mehrstufige Recherchen erhielt am Mittwoch ein Update für professionelle Anwender.

Neu sind ein Vollbild-Report-Viewer und Kontrollfunktionen, mit denen Nutzer vertrauenswürdige Quellen vorgeben und Recherchepläne vor der Ausführung bearbeiten können. Das gibt mehr Granularität und Kontrolle – besonders wichtig für sensible Forschungsbereiche oder hochspezifische Industrieszenarien.

GPT-5-Ökosystem wächst strategisch

Die Spark-Variante ist der nächste Schritt im gezielten Ausbau des GPT-5-Ökosystems. Seit dem Start des Flaggschiff-Modells im August 2025 hat OpenAI die Plattform mit spezialisierten Ablegern für Code (Codex) und Bilder erweitert.

Die Architektur integriert die „Denk“-Fähigkeiten der o-series direkt in das Kernmodell. So kann die KI Rechenressourcen dynamisch je nach Komplexität der Aufgabe zuteilen. Das Spark-Modell scheint eine stromlinienförmte Version davon zu sein: Es priorisiert blitzschnelle Ausführung über tiefes Abwägen – genau dort, wo Latenz das größte Problem ist.

Was bedeutet das für die Zukunft?

Die Branche beobachtet gespannt: Wird das Cerebras-Experiment erfolgreich? Bewältigen die WSE-3-Chips die Millionen täglicher Anfragen von ChatGPT Pro-Nutzern zuverlässig, dürfte OpenAI weitere spezialisierte Modelle auf alternative Architekturen umziehen.

Aktuell ist das Modell nur in der Forschungsvorschau verfügbar. Eine allgemeine API-Freigabe der GPT-5.3-Codex-Familie wird in den kommenden Monaten erwartet. Sie könnte den Markt für KI-gestützte Entwicklungsumgebungen (IDEs) neu ordnen und Wettbewerber wie Anthropic oder GitHub Copilot unter Druck setzen.

Entwickler und Anbieter, die jetzt KI-Systeme integrieren, sollten die neue EU-KI-Regulierung genau kennen. Ein kostenloser Umsetzungsleitfaden erklärt praxisnah Kennzeichnungspflichten, Risikoklassen und die nötige Dokumentation – verständlich für Entwickler und Verantwortliche. Jetzt kostenlosen KI-Verordnungs‑Leitfaden herunterladen

Die Botschaft von OpenAI ist klar: Die Ära des einen Allzweck-KI-Modells neigt sich dem Ende zu. Die Zukunft gehört spezialisierten, hochoptimierten Werkzeugen für einzelne Berufsgruppen – und möglicherweise auch einer diversifizierten Hardware-Landschaft.

@ boerse-global.de

Hol dir den Wissensvorsprung der Profis. Seit 2005 liefert der Börsenbrief trading-notes verlässliche Trading-Empfehlungen – dreimal die Woche, direkt in dein Postfach. 100% kostenlos. 100% Expertenwissen. Trage einfach deine E-Mail Adresse ein und verpasse ab heute keine Top-Chance mehr.

Jetzt anmelden.